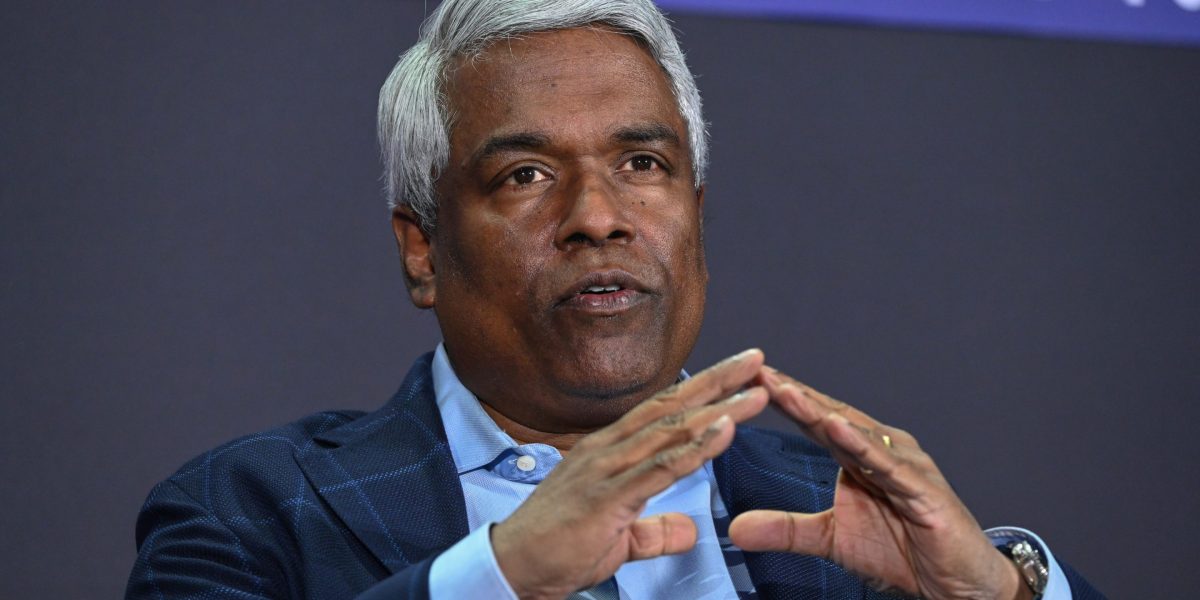

За словами генерального директора Google Cloud Томаса Куріана, величезні потреби штучного інтелекту в електроенергії були помічені на ранньому етапі як вузьке місце, що спонукало Google Cloud від Alphabet планувати, як отримувати енергію та як її використовувати.

Виступаючи на заході Fortune Brainstorm AI у Сан-Франциско в понеділок, він зазначив, що компанія, яка є ключовим чинником інфраструктури штучного інтелекту, працювала над штучним інтелектом задовго до того, як з’явилися великі мовні моделі та взяли довгостроковий погляд.

«Ми також знали, що найпроблемнішою річчю, яка станеться, буде енергетика, тому що енергетичні центри та центри обробки даних стануть вузьким місцем разом із чіпами», — сказав Кур’ян. ФортуниАндрій Нуска. «Тож ми розробили наші машини, щоб вони були надефективними».

Міжнародне енергетичне агентство підрахувало, що деякі центри обробки даних, орієнтовані на штучний інтелект, споживають стільки ж електроенергії, скільки 100 000 будинків, а деякі з найбільших споруд, що будуються, можуть навіть у 20 разів більше.

У той же час, за даними консалтингової компанії Knight Frank, потужність світового центру обробки даних зросте на 46% протягом наступних двох років, що еквівалентно стрибку майже на 21 000 мегават.

На заході Brainstorm Куріан виклав тристоронній підхід Google Cloud до забезпечення того, щоб було достатньо енергії для задоволення всього цього попиту.

По-перше, компанія прагне максимально диверсифікувати види енергії, які забезпечують обчислення ШІ. Хоча багато людей кажуть, що можна використовувати будь-яку форму енергії, насправді це неправда, сказав він.

«Якщо ви запускаєте кластер для навчання, ви відкриваєте його та починаєте виконувати навчальну роботу, сплеск, який ви маєте з цими обчисленнями, забирає стільки енергії, що ви не можете впоратися з цим від деяких форм виробництва енергії», — пояснив Куріан.

Друга частина стратегії Google Cloud полягає в тому, щоб бути максимально ефективним, включаючи те, як вона повторно використовує енергію в центрах обробки даних, додав він.

Насправді компанія використовує штучний інтелект у своїх системах керування для моніторингу термодинамічних обмінів, необхідних для використання енергії, яка вже надана в центри обробки даних.

І по-третє, Google Cloud працює над «декількома новими фундаментальними технологіями для фактичного створення енергії в нових формах», — сказав Куріан, не вдаючись до подробиць.

Раніше в понеділок комунальна компанія NextEra Energy і Google Cloud заявили, що розширюють своє партнерство і розроблять нові кампуси центрів обробки даних у США, які також включатимуть нові електростанції.

Технічні лідери попереджають, що енергопостачання має вирішальне значення для розвитку штучного інтелекту поряд з інноваціями в чіпах і вдосконалених мовних моделях.

Можливість будувати центри обробки даних також є ще однією потенційною проблемою. Генеральний директор Nvidia Дженсен Хуан нещодавно вказав на перевагу Китаю на цьому фронті порівняно зі США

«Якщо ви хочете побудувати центр обробки даних тут, у Сполучених Штатах, від моменту відкриття до створення суперкомп’ютера зі штучним інтелектом може знадобитися близько трьох років», — сказав він у Центрі стратегічних і міжнародних досліджень наприкінці листопада. «Вони можуть побудувати лікарню за вихідні».