Незалежно від того, чи входите ви в обліковий запис банку, медичного страхування чи навіть електронної пошти, більшість служб сьогодні не живуть лише паролями. Багатофакторна автентифікація (MFA) тепер є звичайною справою, яка вимагає від користувачів введення другого або третього підтвердження особи. Однак не всі форми MFA однакові, а одноразові паролі, які організації надсилають на ваш телефон, мають такі великі отвори, що через них можна проїхати вантажівку.

Наприклад, магазин безпеки електронної пошти Abornormal AI задокументував нещодавню серію інцидентів в академічних закладах, де зловмисники змогли підманити жертв не лише ввести свої імена користувачів і паролі, але й одноразовий пароль (OTP), який вони отримали від серверів шкіл.

Використання чиїхось законних облікових даних облікового запису є набагато ефективнішим шляхом для злочинців, ніж пошук діри в безпеці для використання. В останньому звіті Microsoft Digital Defense Report названо особу головним вектором атаки.

Використання MFA будь-якого типу є основним способом запобігти атакам ідентифікаційної інформації, але вам дійсно потрібен метод, який може протистояти фішингу.

«Стійкий до фішингу MFA є золотим стандартом безпеки», — зазначає команда Microsoft з аналізу загроз. «Незалежно від того, наскільки змінюється ландшафт кіберзагроз, багатофакторна автентифікація все ще блокує понад 99 відсотків спроб несанкціонованого доступу, що робить її єдиним найважливішим заходом безпеки, який може застосувати організація».

Зростання кількості ключів доступу

Методи MFA зазвичай поділяються на три категорії: те, що ви знаєте (пароль, код або таємне запитання), те, що у вас є (наприклад, токен або смартфон), або те, що ви є (наприклад, відбитки пальців або сканування обличчя). Вони включають апаратні маркери, програми автентифікації, паролі, надіслані через SMS або електронну пошту, push-повідомлення для схвалення входу на підключеному пристрої та біометричні дані, які використовують фізичні ознаки для підтвердження особи людини.

Історично автентифікація використовувалася за моделлю «щось, що ви знаєте», коли дві сторони – користувач і сервер або два пристрої – підтверджують свою особу, знаючи секрет, як-от пароль або код. Проблема тут полягає в тому, що хтось може здогадатися про ваші секрети, або, можливо, ви помістили це на наліпку чи у текстовий файл на робочому столі.

Злочинці також можуть підманювати ці секрети через фальшиві веб-сайти, які пропонують користувачам ввести своє ім’я користувача та пароль, а також перехоплюють одноразові паролі (OTP), надіслані через SMS або електронну пошту, перенаправляючи повідомлення до того, як вони досягнуть одержувача.

«Однією з речей, які ми спостерігаємо, є повний перехід від паролів до ключів доступу – автентифікація на основі сертифікатів, загорнута в термозбіжну плівку», – сказав віце-президент Forrester і аналітик Андрас Сер. Реєстр.

Ключі доступу – це зазвичай те, що фахівці з безпеки мають на увазі, коли кажуть «захищений від фішингу MFA». Вони замінюють паролі, а натомість використовують пари криптографічних ключів із відкритим ключем, що зберігається на сервері, і закритим ключем, таким як обличчя користувача, відбитки пальців або PIN-код, які зберігаються на пристрої користувача.

Десятки великих веб-сайтів, включаючи Amazon, Google, Microsoft, Apple iCloud, PayPal і WhatsApp, уже застосували ключі доступу як повну альтернативу паролям.

Ключі безпеки (часто під брендом Yubikey), фізичні апаратні пристрої, які зберігають сертифікати X.509, також належать до цієї стійкої до фішингу категорії MFA, оскільки вони вимагають фізичної присутності користувача для автентифікації в обліковому записі та службі.

«На даний момент найбезпечнішими типами автентифікації є ті, що класифікуються як стійкі до фішингу MFA, які можуть бути прив’язаними до пристрою ключами доступу або рідше токенами X.509», – сказав аналітик Gartner Джеймс Гувер. Реєстр. «Для прив’язаних до пристрою ключів FIDO2 наразі не існує перевіреного методу їх «викрадення», оскільки сам закритий ключ не залишає пристрій».

«З ключами доступу ми беремо цю спільну таємну модель і просто роздуваємо всю модель, тому нічого не можна поділитися», — сказав генеральний директор і виконавчий директор FIDO Alliance Ендрю Шикіар. Реєстр.

За допомогою ключів доступу ми беремо спільну секретну модель і просто роздуваємо всю модель, тому нічого не можна поділитися

Крім того, є ключі доступу для кількох пристроїв – синхронізовані облікові дані, які дозволяють користувачам входити в програми на будь-якому зі своїх пристроїв і зберігаються в менеджері облікових даних, як-от Google Password Manager, iCloud Keychain або Bitwarden з відкритим кодом. Але вони відкриті для атак соціальної інженерії.

«Це усуває незручність повторної реєстрації кожного пристрою, але це потенційно відкриває вам доступ до рівня соціальної інженерії, оскільки я можу отримати доступ до цього ключа, переконавши вас дозволити мій пристрій у ваш обліковий запис», — сказав Гувер.

Він говорить про атаки соціальної інженерії в стилі Scattered-Spider, а не про фішинг, під час яких зловмисники зазвичай збирають інформацію про співробітника з соціальних мереж та інших публічних джерел, а потім видають себе за нього під час дзвінка в ІТ-службу компанії, зрештою переконуючи службу підтримки скинути облікові дані або пристрої MFA.

«Але вони все ще представляють собою значний крок вперед у порівнянні з більш часто використовуваними методами пароля, SMS або електронної пошти OTP», — додав Гувер.

Прийняття ключа доступу швидко набирає обертів

Альянс FIDO – Fast Identity Online – створений у 2012 році для вирішення проблеми несумісності між надійними технологіями автентифікації та вирішення проблеми користувачів із запам’ятовуванням занадто великої кількості імен користувачів і паролів на веб-сайтах і в службах. Перші учасники альянсу FIDO, включаючи Apple, Google, Microsoft, почали розробку стандартів FIDO2 і WebAuthn для автентифікації без пароля в 2019 році, а громадськість вперше побачила ключі доступу у вересні 2022 року, коли Apple почала підтримувати їх у своїх комп’ютерних операційних системах iPhone, iPad і Mac.

Через три роки “за нашими оцінками, використовується понад 2 мільярди ключів доступу”, – сказав Шикіар.

«Це чудово – це значуще число – і ми хотіли б, щоб воно зросло до 5-10 мільярдів, що дійсно перетне поріг повернення назад», – додав він. «Але 2 мільярди для технологій, які були широко доступні протягом приблизно трьох років, ми відчуваємо себе досить добре щодо цього прогресу».

Liminal, консалтингова фірма, що спеціалізується на цифровій ідентифікації, провела опитування 200 ІТ-фахівців, які або вже застосували ключі доступу, або пообіцяли це зробити. Було виявлено, що 63 відсотки респондентів назвали ключі доступу своїм головним пріоритетом для інвестицій у автентифікацію на 2026 рік. З тих, хто вже впровадив ключі доступу, 85 відсотків повідомили про велике задоволення своїм рішенням і досягнутими на даний момент бізнес-результатами.

Щоб дослідити бізнес-вигоди ключів доступу, обидві фірми провели конфіденційне опитування [PDF] із дев’яти членських організацій – Amazon, Google, LY Corporation, Mercari, Microsoft, NTT DOCOMO, PayPal, Target і TikTok – які впроваджували їх протягом від одного до трьох років.

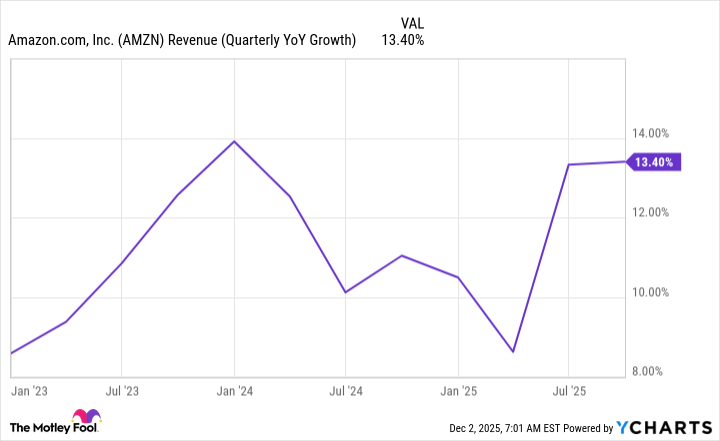

Ці компанії повідомили про 30% вищий рівень успішного входу в систему порівняно з іншими методами MFA, і сказали, що ключі доступу скорочують час входу на 73%, займаючи в середньому 8,5 секунди на вхід.

Інші методи автентифікації, включаючи перевірку електронної пошти, коди SMS і параметри входу через соціальні мережі (вхід через Apple, Google тощо), займали в середньому 31,2 секунди.

«Якщо ви займаєтеся продажем речей або контенту, простіший і швидший доступ призведе до збільшення доходів», — сказав Шикіар, зазначивши, що простота використання ключів доступу допомагає бізнесу, орієнтованому на споживача, усунути залишення кошика для покупок через те, що люди розчаровуються через час, необхідний для оформлення покупки.

«Але також ті, хто першими прийняли рішення, знаходять зниження витрат», — сказав він.

Ключі доступу зменшують кількість дзвінків у службу підтримки, згідно з першими користувачами, які повідомили на 81 відсоток про менше випадків, пов’язаних із входом у службу підтримки. Хоча вони не вказали суму в доларах, компанії, які використовують ключі доступу, кажуть, що також очікують економії коштів, оскільки ця форма автентифікації зменшує витрати, пов’язані з OTP, скиданням і взаємодією з підтримкою.

Крім того, за словами Шикіара, ключі доступу усувають витрати, пов’язані з шахрайством із SMS та OTP. «Якщо облікові записи не можуть бути захоплені дистанційними атаками, ваші атаки зменшуються, а витрати на шахрайство зменшуються».

Проблеми з юзабіліті залишаються

Тож чому не всі використовують ключі доступу? Залишаються деякі проблеми з зручністю використання, особливо з ключами доступу, прив’язаними до пристроїв однієї операційної системи (наприклад, iOS, Android або Windows), які зазвичай вимагають інструментів сторонніх розробників для перенесення в іншу екосистему ОС.

«Завжди є компроміс між безпекою та простотою впровадження», — сказав Авінаш Раджив з PwC, який очолює бізнес консалтингової фірми США з кіберризиків, даних і технологічних ризиків. Реєстр.

«Для випадків внутрішнього використання, як-от співробітників і підрядників, безпека зазвичай є найважливішою, і ви можете уникнути найкращого досвіду роботи з вашим внутрішнім населенням», — сказав він. «Але коли ви дивитеся на зовнішню сторону клієнтів, то вам потрібно віддати пріоритет користувацькому досвіду, і іноді це відбувається за рахунок безпеки. Це завжди зводиться до пошуку правильного балансу».

Хоча коди доступу через SMS або електронну пошту не такі безпечні, як ключі доступу, багато веб-сайтів, які звертаються до клієнтів, усе ще використовують їх, оскільки їх легше застосувати та зрозуміти. У клієнта вже є адреса електронної пошти, і якщо він не проти почекати ще кілька секунд, щоб отримати маркер безпеки, це простий процес. Крім того, це ще безпечніше, ніж просто використання пароля.

“Це завжди поєднання обох цих факторів”, – сказав Раджив. «Ви повинні завжди дивитися на те, що ви намагаєтеся захистити, і що ви готові прийняти з точки зору рівня безпеки, в той же час переконавшись, що користувальницький досвід залишається достатньо прийнятним для вашої групи користувачів». ®